Bei OpenAIs Report State of Enterprise AI herausgekommen ist eine Lobeshymne auf die eigenen Werkzeuge, unterfüttert mit unkonkreten Zahlen und bauchgefühliger Korrelation. Die Nutzerzahlen sind alle unkonkrete Faktorangaben, ohne eine Ausgangs- und Endsumme. Dass Powernutzer die Tools intensiver und häufiger nutzen, verwundert kaum, allerdings fehlen auch hier konkrete Zahlen und ein Bezug zur Gesamtwirtschaft – denn der allgemeine Bericht bezieht sich nur auf Kunden, die ein Jahresabo abgeschlossen haben. Ob es Abonnements ohne aktive Nutzer gibt, fehlt auch. Weiterhin ist keine Spur von Messbarkeit: Nutzer berichten von Effizienz und gesparten Stunden, OpenAI kann aber nur eingesetzte Token messen. Vorn und hinten fehlen konkrete Zahlen. Ganz besonders dabei, einen Kosten-/Nutzen-Faktor abzuschätzen und so eine wirtschaftliche Entscheidung zu treffen.

Keine Kosten-Nutzen-Rechnung möglich

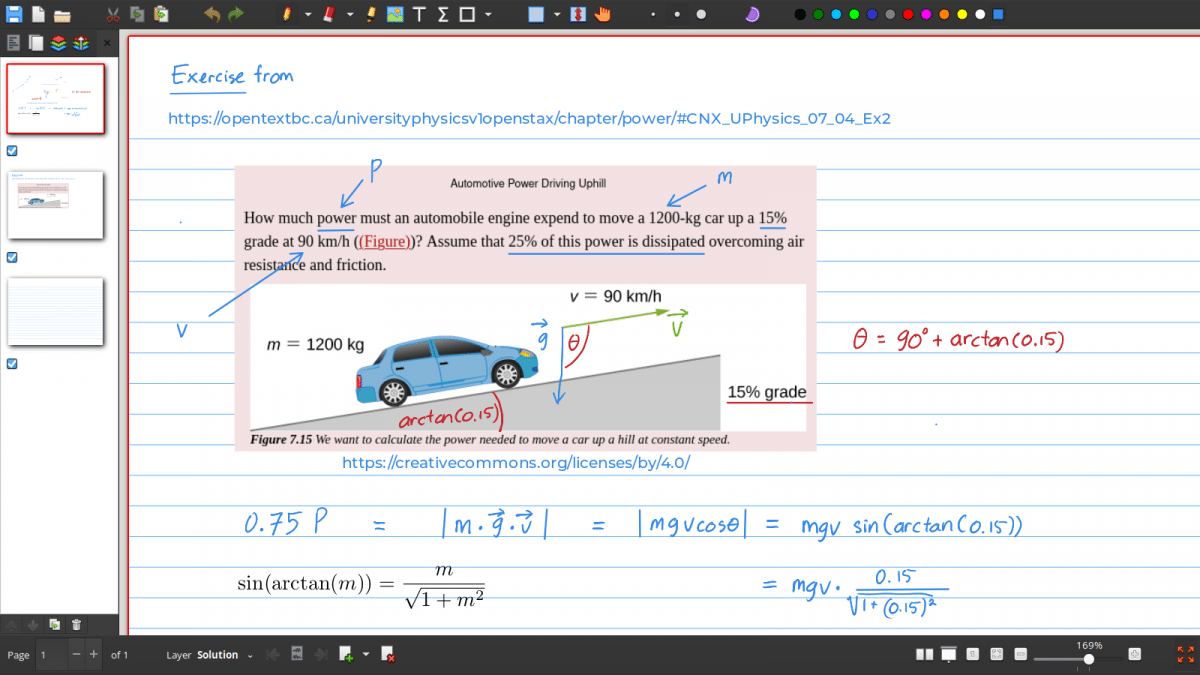

Eine Ersparnis von mehr als zehn Arbeitsstunden durch ChatGPT geht mit dem Konsum von 1200 Credits einher, die aber keine echte Rechnungsgröße in OpenAIs Preistabellen sind. Hier gibt es Abos, Nutzungslimits und Token in der API. Während sich zu den Limits der Enterprise-Version auf der Hilfeseite von OpenAI keine Informationen finden ließen, so ist etwa der Einsatz von GPT-5 Pro bei Business auf 15 Anfragen pro Nutzer im Monat limitiert – Zukauf möglich. Im Bericht beschreibt OpenAI die Credits wage als Annäherung an die Nutzung, bei der fortgeschrittene Features wie Codex oder Deep Research mehr verbrauchen: „Credits map to usage, with more advanced features like Codex and Deep Research consuming an higher number of credits“.

Selbst an der Stelle, an der OpenAI Token angibt, lassen sich die genauen Kosten nicht erfassen. Während Input-Token günstiger sind, liegen die wahren Kosten in den Output-Token der Modelle. Besonders beim Reasoning fallen davon viele an – denn der gesamte Reasoning-Verlauf vor der eigentlichen Antwort sind Output-Token. In einem Agentensystem, etwa über das MCP, könnten diese Token auch erneut zum Input werden, mit dem ein weiteres Modell neuen Output generiert. Während In- und Output bei GPT-5.1 1,25 US-Dollar beziehungsweise 10 US-Dollar pro Million Token kosten, liegt der Preis von GPT-5 Pro bei 15 Dollar und 120 Dollar für eine Million In- und Output-Token. Nutzen Unternehmen nun 10 Milliarden oder sogar eine Billion Token, so geht aus OpenAIs Veröffentlichung trotzdem kein genauer Preis hervor. Es ließe sich schätzen und mitteln, je nach Einsatzfeld variiert jedoch die Menge der Token. Für das Finden von Informationen werfen Nutzer viele Token in das System und erwarten eine kürzere Antwort; Reasoning hingegen kann schon aus einer kurzen Eingabe viel Output machen.

Nur KI-Chatbots draufwerfen hilft nicht

Die großen Sprachmodelle werden offenkundig besser. Information Retrieval mit RAG funktioniert gut, FAQ-Bots entlasten Service-Hotlines, Programmierer können schneller Prototypen aus dem Ärmel schütteln lassen und MCP verknüpft verschiedene Schnittstellen miteinander. Allerdings fehlt ein Business-Case, der die gesamte Komplexität der Stellen von Facharbeitern erfassen kann. In den meisten Beispielen sammeln die LLMs Informationen aus aggregierten oder gegebenen Dokumenten und geben das Ergebnis an Facharbeiter oder Hilfe suchende Kunden weiter. Bereits teure Angestellte bekommen Hilfe von teurer Technik, oder Callcenter werden teilautomatisiert.

Besonders Unternehmen, die bereits bei der Digitalisierung hinterherhinken, können nur mit Chatbots nicht einfach so aufholen. Das aufwendige Feintuning eines Modells löst Anschlussängste aus, wenn zwei Monate später ein besseres Basismodell herauskommt, das dann über Foren, soziale und klassische Medien hinweg verherrlicht wird. Will man flexibel sein, baut man einen Techstack und Pipelines um eine Schnittstelle auf; trotzdem lassen sich die LLMs nicht so richtig als Drop-in Replacements verwenden. Jedes Modell und jede Modellversion haben eigene Charakterzüge und Schwächen, auf die der Stack dann wieder anzupassen ist. Externe Dienstleister versprechen KI und müssen erst einmal ein Fundament für digitale Prozesse legen.

OpenAIs Bericht erzeugt Anschlussängste

Das größte Problem ist jedoch die Messbarkeit von Effizienzgewinnen, die kaum gegeben ist. Berichte über gesparte Stunden stehen den undurchsichtigen Geschäftsmodellen der KI-Anbieter gegenüber, die nachweislich ihre Kosten derzeit nicht decken können und den Kunden über Abomodelle oder intransparente Preisgestaltung die echten Kosten der Systeme bisher nicht weitergeben. Währenddessen planen KI-Anbieter Milliardenausgaben für Infrastrukturprojekte, die auch wieder reinzuholen sind. Eine Cursor-Anthropic-Situation könnte jederzeit wieder eintreten, bei der ein Anbieter die Preise schlagartig erhöht oder die Kapazitäten drosselt. Das Ziel der Anbieter der am weitesten verbreiteten Tools ist der Vendor-Lockin. Mit dem stärksten Alltagsnutzer-Fokus sind das OpenAI und Google, bei Entwicklern haben Microsoft und Anthropic die Nase recht weit vorn. Das Aufbauen oder Erweitern von eigener Infrastruktur für den Betrieb von generativen KI-Modellen ist ebenfalls mit massiven Kosten verbunden, besonders, da neben den teuren KI-Beschleunigern auch andere Hardware gerade hohe Kosten verursacht.

OpenAIs Bericht will Entscheidern Angst machen, mit dem eigenen Unternehmen den Anschluss an die Wirtschaft zu verlieren. Und beschönigt gleichzeitig mit nicht nachvollziehbaren Zahlen die Realität. Nur durch das Jahresabo von ChatGPT Enterprise finden Unternehmen nicht den Anschluss in der Digitalisierung, auch nicht, wenn sie zusätzlich für tausende Euro Token und Credits verbrennen, um Arbeitsstunden zu sparen.

(pst)

English (US) ·

English (US) ·